避免重復(fù)造輪子,前提是輪子已經(jīng)造得很好。

大模型有多卷?

現(xiàn)在國內(nèi)已經(jīng)有180個以上生成式大模型,科技大廠、互聯(lián)網(wǎng)大廠紛紛入局,既有百度、浪潮信息、阿里、騰訊等一眾巨頭,也有專攻AI的訊飛、商湯等垂直領(lǐng)域小巨頭,以及“日日新”的創(chuàng)業(yè)企業(yè)。

今天A廠商發(fā)布大模型,各種參數(shù)對比下來堪稱最強,第二天B廠商發(fā)布下來,又刷新了各種記錄。最強、最大、強快,有可能只保持一天。這說明什么?基礎(chǔ)大模型還有很大的進化空間。

11月27日,算力龍頭企業(yè)浪潮信息發(fā)布了完全開源且可免費商用的源2.0基礎(chǔ)大模型,包含1026億、518億、21億不同參數(shù)規(guī)模,這也是國內(nèi)首個千億參數(shù)、全面開源的大模型。

作為一家做算力基礎(chǔ)設(shè)施的公司,為什么如此努力地卷大模型?浪潮信息高級副總裁、AI&HPC總經(jīng)理劉軍表示:最終用戶感受到的大模型能力是其在應(yīng)用層面能力的表現(xiàn),這些核心能力的本質(zhì),是由基礎(chǔ)大模型能力所決定的。在他看來,今天模型基礎(chǔ)能力與客戶預(yù)期之間仍有較大的差距,這也是浪潮信息不斷探索的原因所在。

GPT4不是天花板,百模大戰(zhàn)探索“更優(yōu)解”

GPT3.5的發(fā)布,算得上是AI產(chǎn)業(yè)發(fā)展的一個重要拐點,很多人將之稱為AI的“蘋果時刻”。今年3月,OpenAI發(fā)布了GPT4,GPT4的能力比GPT3.5有一個巨大的提升,GPT4是當(dāng)前業(yè)界最先進的技術(shù)大模型。

但是,即便是當(dāng)前公認最先進的大模型,GPT4其實也還有很多挑戰(zhàn)沒有解決。

比如算力短缺,一直是OpenAI在其迅速崛起過程中不得不面對的一個棘手問題。當(dāng)用戶海量涌入的時候,OpenAI已經(jīng)出現(xiàn)過幾次崩潰的情況。為此,OpenAI采用了不同級別的會員收費,對用戶進行分層。并且還一度還采用停止注冊的方式來限制用戶的使用量,緩解算力壓力。

再比如AI幻覺。今天的GPT4給出的答案并不完全正確,有時候會有明顯的事實錯誤,有時候也會一本正經(jīng)地胡說八道。這里面也有很多原因,比如數(shù)據(jù)來源的問題,再比如不同法律體系、不同價值觀下的分歧等等。

GPT4遇到的挑戰(zhàn)還有很多,這些都是整個行業(yè)正在面臨的挑戰(zhàn)。今天,看上去大模型這個領(lǐng)域非常卷,但本質(zhì)上還是處于產(chǎn)業(yè)初期。一方面,國產(chǎn)基礎(chǔ)大模型的能力和 Open AI 之間存在較大的差距,另一方面即使是最先進的GPT4,現(xiàn)在的能力還處于初級階段,很多問題依舊在探索開發(fā)。

通用大模型基座作為通用人工智能的核心基礎(chǔ)設(shè)施,被嵌入到智能助手、機器翻譯、自動化客服等場景中,從而實現(xiàn)更加個性化、智能化、自適應(yīng)的服務(wù)和應(yīng)用。IDC預(yù)測,到2026年,全球AI計算市場規(guī)模將增長到346.6億美元,生成式AI計算占比從22年4.2%增長到 31.7%。

通用大模型是大模型產(chǎn)業(yè)的地基,地基的深度和強度決定大廈的高度。大模型和應(yīng)用之間的關(guān)系,如果用上學(xué)和工作來比喻:大模型是12年小初高階段,垂直行業(yè)大模型是大學(xué)分專業(yè)學(xué)習(xí)的階段,應(yīng)用則是進入到工作崗位開始為企業(yè)、社會創(chuàng)造價值的階段。

今年掀起百模大戰(zhàn)之后,業(yè)界有一種觀點認為不應(yīng)該浪費資源重復(fù)造輪子。但前提是輪子已經(jīng)比較成熟,如果今天的輪子還不好用,就值得更多的企業(yè)投入進來,探索各種不同的路徑來把輪子造好。所以,最近業(yè)內(nèi)正在形成新的共識:在產(chǎn)業(yè)初期,適度的泡沫還是必要的。中國大模型的“百花齊放”是利好的,很大程度它可以激活創(chuàng)新,促進產(chǎn)業(yè)生態(tài)的繁榮發(fā)展。

浪潮信息人工智能軟件研發(fā)總監(jiān)吳韶華

浪潮信息人工智能軟件研發(fā)總監(jiān)吳韶華

“確實在當(dāng)前大模型百花齊放的態(tài)勢下,必然大家會有不同的實現(xiàn)路徑,也會有理念沖突,這都是特別正常的事情。因為畢竟大家都在探索,都沒有出來一條非常有效的路徑。” 浪潮信息人工智能軟件研發(fā)總監(jiān)吳韶華表示。

浪潮信息為什么也要進來一起卷大模型?浪潮信息左手有做大模型的伙伴,右手有做垂直行業(yè)應(yīng)用的伙伴,可以說既懂底層技術(shù)又有上層應(yīng)用經(jīng)驗。更重要的是作為一家算力基礎(chǔ)設(shè)施公司,在產(chǎn)業(yè)初期,浪潮信息在算力上的探索會給整個產(chǎn)業(yè)帶來很大的推動力,比如算力資源的高效性、算力集群的可擴展性、算力系統(tǒng)的可持續(xù)性,這些都能讓算力更充分地釋放出來,這對整個產(chǎn)業(yè)都有極大的價值。

浪潮信息做大模型主要是兩個維度的探索:一是探索路徑、方法,比如有什么架構(gòu)可以節(jié)省算力,什么模型可以讓數(shù)據(jù)更精準等等。二是探索邊界,今天大模型已經(jīng)能做很多事,但隨著算力、算法、數(shù)據(jù)的迭代,新的能力也不斷被挖掘出來,大模型的上限到底在哪里?

看上去已經(jīng)很激烈的百模大戰(zhàn),只是生成式AI的起點。通用大模型是一項異常復(fù)雜的系統(tǒng)工程,需從系統(tǒng)層面達以創(chuàng)新,從算力效率、線性擴展、長效穩(wěn)定等多個方面進行探索。今天,沒有哪個企業(yè)有絕對的優(yōu)勢,算力、算法、數(shù)據(jù)三要素都有很大的進化空間,此外還需要更好的應(yīng)用來落地大模型的價值。也就是說,大模型還要卷,同時應(yīng)用也要卷,打通一個能持續(xù)跑起來的飛輪生態(tài),百模大戰(zhàn)的效果才真正實現(xiàn)了。

基因、智商、情商,打造“三高”大模型

作為最早布局大模型的企業(yè)之一,浪潮信息早在2019年就推出了中文AI巨量模型“源1.0”,是當(dāng)時最大參數(shù)的大模型。“源”大模型的數(shù)據(jù)集和清洗經(jīng)驗和幫助國內(nèi)不少AI團隊提升了其大模型的性能表現(xiàn),比如助力網(wǎng)易伏羲中文預(yù)訓(xùn)練大模型“玉言”登頂中文語言理解權(quán)威測評基準CLUE分類任務(wù)榜單,并在多項任務(wù)上超過人類水平。過去的兩年,源1.0大模型的智能力與To B領(lǐng)域復(fù)雜的服務(wù)場景進行深度融合,構(gòu)建專家級數(shù)據(jù)中心智能客服大腦,榮獲哈佛商業(yè)評論鼎革獎。

但是,源1.0開放出來之后,在客戶的應(yīng)用場景中遇到了很多具體的問題。所有這些問題,都是浪潮信息升級源2.0的發(fā)出點。此外,GPT4是一個封閉的系統(tǒng),就是一個黑盒子,大家不知道它是怎么做的。那么,中國的大模型也需要更多的創(chuàng)新,才有機會去超越GPT4。

簡單來講,浪潮信息源2.0在數(shù)據(jù)、算力、算法三個維度向前邁進了一大步。在懂懂看來,數(shù)據(jù)決定大模型的基因,算力是決定大模型的智商,算法決定大模型的情商,所以這是“更聰明“的大模型的核心三要素,源2.0就是一個“三高”大模型。

先說說數(shù)據(jù)。

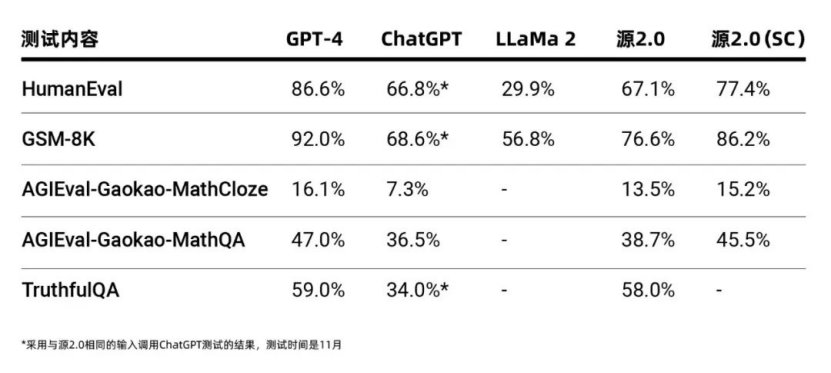

“在有限的算力資源上,訓(xùn)練數(shù)據(jù)的質(zhì)量,直接決定了模型的性能,這個性能主要是指模型的智能化水平在任務(wù)上的表現(xiàn)。” 吳韶華強調(diào),數(shù)據(jù)體量很重要,但是數(shù)據(jù)質(zhì)量更重要。在源2.0中,浪潮信息的思路就是進一步提純數(shù)據(jù),讓模型能基于更高水平的數(shù)據(jù)來訓(xùn)練。

具體而言,源2.0通過使用中英文書籍、百科、論文等資料,結(jié)合高效的數(shù)據(jù)清洗流程,為大模型訓(xùn)練提供了高質(zhì)量的學(xué)科專業(yè)數(shù)據(jù)集和邏輯推理數(shù)據(jù)集。除此之外,為了更高效地獲得高質(zhì)量的代碼數(shù)據(jù)集,浪潮信息提出基于主題詞或Q&A問答對自動生成編程題目和答案的數(shù)據(jù)集生成流程,提高了數(shù)據(jù)集問題的多樣性和隨機性;同時提出基于單元測試的數(shù)據(jù)清洗方法,可以更加高效地獲取高質(zhì)量數(shù)據(jù)集,提高訓(xùn)練效率。

“我們這套數(shù)據(jù)構(gòu)建方法,能夠比較有效的解決互聯(lián)網(wǎng)海量數(shù)據(jù)清洗問題。我們后續(xù)的計劃是用我們的模型產(chǎn)生更高質(zhì)量的數(shù)據(jù),然后持續(xù)迭代,來提升我們大模型的能力。”劉軍表示。

接下來講一下算法。

傳統(tǒng)Transformer結(jié)構(gòu)被業(yè)界廣泛采用,但是對中文的識別并不是最佳模式。源2.0有一個很大的創(chuàng)新,就是把attention(自注意力)這一層,采用了自研的新型LFA(Localized Filtering-based Attention)結(jié)構(gòu),中文名字是局部注意力過濾增強機制。考慮到自然語言輸入的局部依賴性,LFA通過先強化相鄰詞之間的關(guān)聯(lián)性,然后再計算全局關(guān)聯(lián)性的方法,有效地解決了傳統(tǒng)Transformer結(jié)構(gòu)中對所有輸入的文字一視同仁,不能考慮自然語言相鄰詞之間的強語義關(guān)聯(lián)的問題,能夠更好地處理自然語言的語序排列問題,對于中文語境的關(guān)聯(lián)語義理解更準確、更人性,提升了模型的自然語言表達能力,進而提升了模型精度。

“我們發(fā)現(xiàn)在源2.0這個階段,依然是處于研究方向的初級階段,后面還有很多的可能性。圍繞著這個方向,我們團隊也會繼續(xù)研究下去,來嘗試進一步的得到更好的模型結(jié)構(gòu)。” 吳韶華表示。

最后再來說說計算。

全球算力緊缺是一個短期內(nèi)很難緩解的痛點,所以計算的調(diào)優(yōu),是整個產(chǎn)業(yè)都迫切需要突破的瓶頸,而這也恰好正是浪潮信息的優(yōu)勢所在。

為了在各類計算設(shè)備上都有一個非常好的計算性能表現(xiàn),源2.0中提出了非均勻流水并行+優(yōu)化器參數(shù)并行(ZeRO)+數(shù)據(jù)并行的策略。相較于經(jīng)典的三維并且方法,創(chuàng)新算法有更好的適用性,顯著降低了經(jīng)典大模型訓(xùn)練過程中對于AI芯片之間的通訊帶寬需求,同時還能獲得非常高的性能表現(xiàn)。

大模型算力系統(tǒng)并不是算力的簡單堆積,其需要解決低時延海量數(shù)據(jù)交換的挑戰(zhàn);需要解決多臺機器均衡計算、避免冷熱不均、消弭算力堵點的問題;需要解決在幾個月漫長的計算過程中,當(dāng)單一硬件出現(xiàn)故障時,訓(xùn)練中斷、梯度爆炸、算法重新走一遍等等問題。所以,源2.0也不是浪潮信息的最終“答卷”。盡管源2.0已經(jīng)擁有非常出色的表現(xiàn),但是在劉軍看來,這只是開了個頭,未來還有很多值得挖掘的方向,浪潮信息會不斷創(chuàng)新升級。

卷大模型還是卷應(yīng)用?都要從開源中找答案

是應(yīng)該卷模型還是卷應(yīng)用?業(yè)界是有不同觀點的。

很多做大模型的企業(yè),都主張應(yīng)該卷應(yīng)用。現(xiàn)在百模酣戰(zhàn),是不是可以向前邁一步,開始卷應(yīng)用了?

百度李彥宏在今年3月份就提出下一步的方向是大模型的應(yīng)用,隨后在10月份的百度大會上一口氣發(fā)布了幾十個原生應(yīng)用。從做大模型的企業(yè)來看,一定是在自己的模型上卷應(yīng)用,讓模型不斷進化,讓應(yīng)用價值不斷落地,這是沒有錯的。

浪潮信息高級副總裁、AI&HPC總經(jīng)理劉軍

浪潮信息高級副總裁、AI&HPC總經(jīng)理劉軍

那為什么還有那么多企業(yè)參與到百模大戰(zhàn)當(dāng)中呢?中國的大模型與GPT4還有或多或少的差距,即使是GPT4也還沒有進化到天花板,也依然有很大的提升空間。此外,劉軍認為未來的生成式AI是多元化生態(tài),每個基礎(chǔ)大模型可能會有不同的擅長領(lǐng)域。

所以,放到整個產(chǎn)業(yè)的視角來看,大模型和應(yīng)用都要卷:一方面需要繼續(xù)提升基礎(chǔ)大模型的能力,因為只有基礎(chǔ)大模型做好了才能更好地實現(xiàn)行業(yè)落地;另一方面,需要在應(yīng)用落地方面繼續(xù)創(chuàng)新。只有大模型側(cè)和應(yīng)用側(cè)同時發(fā)力,雙輪驅(qū)動,生成式AI的發(fā)展甚至是中國的AI產(chǎn)業(yè)才會有更好的前景。

雙輪驅(qū)動,怎么卷才能最高效?答案是:開源。

在移動互聯(lián)網(wǎng)時代,有一個封閉的iOS系統(tǒng),還有一個開源的安卓系統(tǒng)。蘋果很強大,自己就支撐了一個生態(tài)。但安卓更強大,開放的安卓系統(tǒng)吸引更多的手機廠商,更多的開發(fā)者,也衍生出一個更龐大的生態(tài)。

今年上半年,Meta的LLaMA開源,給業(yè)界開了一個好頭。正是看到開源的能量,國內(nèi)的大模型也紛紛加入開源的陣營,包括阿里云、百川、智譜AI、清華EKG等等。這一次源2.0也徹底開源,并且這是行業(yè)首個千億開源大模型。

“完全免費、完全可商用、不需要授權(quán)、最徹底的開源。”吳韶華表示,浪潮信息希望通過開源真正的能夠普惠產(chǎn)業(yè)用戶,個人開發(fā)者,讓大家能夠通過源2.0構(gòu)建更強的AI系統(tǒng)。

劉軍強調(diào),開源最本質(zhì)的好處是讓整個產(chǎn)業(yè)能夠協(xié)同發(fā)展,“回顧過去所有成功的開源項目,都是因為整個社區(qū)共同貢獻的結(jié)果。”

首先,開源可以建立一個高效的反饋閉環(huán),通過應(yīng)用反哺大模型,加速大模型的進化。

浪潮信息希望通過開源吸引更多的開發(fā)者進來,同時發(fā)起了大模型共訓(xùn)計劃,開發(fā)者可以在源2.0上自由地開發(fā),如果遇到問題可以反饋給浪潮信息,盡快地提升模型的能力。

其次,開源可以更廣泛地賦能行業(yè)、賦能企業(yè),加速大模型價值的落地。

優(yōu)秀開源模型是吸引開發(fā)者、繁榮生態(tài)的關(guān)鍵因素。以開放的心態(tài)開源,給開發(fā)者更強有力的支持,他們可以直接調(diào)用API、中文數(shù)據(jù)集、模型訓(xùn)練代碼等,大大降低開發(fā)者將大模型能力適配不同場景的難度,加速應(yīng)用的落地,讓企業(yè)盡快吃到AI時代的紅利。

所以,無論是卷大模型還是卷應(yīng)用,開源都是一條光明大道。

【結(jié)束語】

在諸多大模型中,浪潮信息也卷了進來。與其它大模型不同之處,就是其在計算方面的優(yōu)勢,通過算力的產(chǎn)品和技術(shù)的創(chuàng)新推動數(shù)字化、智能化的發(fā)展。

源從1.0進化到2.0,給產(chǎn)業(yè)打個樣,通過智算的力量去訓(xùn)練生成式AI大模型,浪潮信息的很多探索成果,可以賦能加速AI產(chǎn)業(yè)化和產(chǎn)業(yè)AI化的進步。